Bevor wir in den DeLorean springen und durch die Zeit reisen, lassen Sie uns erst einmal orientieren. Virtualisierung ist wie dieser Zaubertrick, bei dem man mehrere Kaninchen in einen Hut stopft. Nur dass es hier nicht um Kaninchen geht, sondern um Betriebssysteme, und statt eines Hutes ist es ein einzelner physischer Server.

Virtualisierung: Die Kunst, einen Computer so zu tun, als wäre er viele Computer, ohne dass er eine multiple Persönlichkeitsstörung braucht.

Aber warum sich die Mühe machen? Stellen Sie sich vor, Sie sind ein Systemadministrator (mein Beileid, wenn Sie es tatsächlich sind). Sie haben eine Menge Anwendungen, die jeweils ihre eigene Umgebung benötigen. Ohne Virtualisierung bräuchten Sie für jede Anwendung einen separaten Server. Das bedeutet viel Hardware, viel Strom und viele Kopfschmerzen. Virtualisierung ermöglicht es Ihnen, all das auf weniger Maschinen zu konsolidieren, was Platz, Energie und Ihre Nerven spart.

Der Beginn der Virtualisierung in Linux: Erste Schritte

Die Virtualisierungsreise von Linux begann mit Technologien wie Xen und KVM (Kernel-based Virtual Machine). Diese waren die ersten Vorboten eines seismischen Wandels in der Art und Weise, wie wir Server verwalten.

Xen: Der Pionier der Linux-Virtualisierung

Xen war wie das coole Kind, das mit einem Tamagotchi in die Schule kam, während alle anderen noch mit Stöcken spielten. Es führte das Konzept eines Hypervisors ein - eine Schicht, die zwischen der Hardware und den virtuellen Maschinen sitzt, Ressourcen verwaltet und dafür sorgt, dass alles reibungslos läuft.

KVM: Der Favorit der Massen

Dann kam KVM, das wie der zugänglichere Cousin von Xen war. Es verwandelte den Linux-Kernel selbst in einen Hypervisor. Plötzlich hatte jedes Linux-System das Potenzial, ein Virtualisierungs-Kraftpaket zu sein. Es war, als ob Linux sagte: "Hey, das kann ich auch, und ich mache es, während ich deine regulären Arbeitslasten ausführe!"

# KVM-Modul laden

modprobe kvm-intel # Für Intel-Prozessoren

# oder

modprobe kvm-amd # Für AMD-Prozessoren

# Überprüfen, ob KVM geladen ist

lsmod | grep kvm

Das Zeitalter der Hypervisoren: Xen vs. KVM Showdown

Als Xen und KVM reiften, wurden sie zu den Schwergewichten der Virtualisierungswelt. Lassen Sie uns ihre wichtigsten Unterschiede aufschlüsseln:

| Merkmal | Xen | KVM |

|---|---|---|

| Architektur | Typ 1 (Bare-metal) Hypervisor | Typ 2 (Hosted) Hypervisor |

| Integration mit Linux | Getrennt vom Kernel | Teil des Linux-Kernels |

| Benutzerfreundlichkeit | Komplexere Einrichtung | Einfacher zu starten |

| Leistung | Hervorragend für Paravirtualisierung | Großartig für hardwareunterstützte Virtualisierung |

KVM wurde schließlich zum Liebling der Linux-Welt. Warum? Es war, als würde man herausfinden, dass das vertraute Schweizer Taschenmesser auch einen eingebauten Espressokocher hat. KVM nutzte die bestehende Linux-Infrastruktur, was es für Administratoren einfacher machte, es zu übernehmen und zu verwalten.

Containerisierung: Die Virtualisierung bekommt ein Makeover

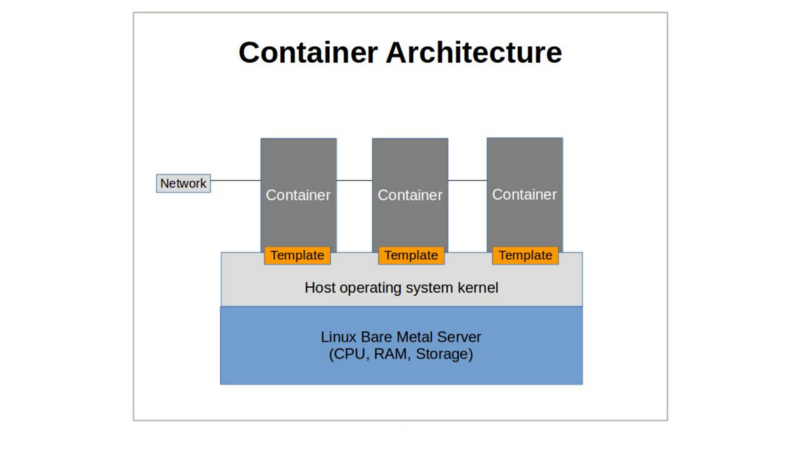

Gerade als wir dachten, Virtualisierung könnte nicht cooler werden, stürmten Container die Party. Betreten Sie LXC (Linux Containers), den hippen Cousin der virtuellen Maschinen.

LXC: Der Container-Pionier

LXC war wie: "Hey, was wäre, wenn wir auf Betriebssystemebene statt auf Hardwareebene virtualisieren?" Es nutzte die cgroups und Namespaces von Linux, um isolierte Umgebungen innerhalb eines einzigen Betriebssystems zu schaffen. Leichter, schneller und ressourcenschonender als vollständige VMs.

Docker: Container werden Mainstream

Dann kam Docker und machte für Container das, was das iPhone für Smartphones tat. Es machte sie zugänglich, portabel und, wage ich zu sagen, sexy?

FROM ubuntu:20.04

RUN apt-get update && apt-get install -y nginx

EXPOSE 80

CMD ["nginx", "-g", "daemon off;"]

Plötzlich konnten Entwickler ihre Anwendungen mit allen Abhängigkeiten verpacken und überall hin verschicken. Es war wie: "Hier ist meine App in einer Box. Euer Problem jetzt, Ops-Team!"

cgroups und Namespaces: Das Geheimnis der Container

Im Herzen der Container-Magie stehen zwei Schlüsseltechnologien von Linux: cgroups und Namespaces. Denken Sie an sie als den Türsteher und den VIP-Raum der Containerwelt.

cgroups (Control Groups)

cgroups sind wie der strenge Elternteil der Linux-Welt. Sie kontrollieren, wie viele Ressourcen (CPU, Speicher, Festplatten-I/O, Netzwerk usw.) ein Prozess oder eine Gruppe von Prozessen nutzen kann. Es ist wie zu sagen: "Du kannst so viel Kuchen haben, und nicht ein Krümel mehr!"

Namespaces

Namespaces hingegen drehen sich um Isolation. Sie sind wie diese geräuschunterdrückenden Kopfhörer für Prozesse. Jeder Namespace begrenzt, was ein Prozess im System sehen und darauf zugreifen kann. Es gibt mehrere Typen: - PID-Namespace: Prozessisolation - Netzwerk-Namespace: Netzwerkisolation - Mount-Namespace: Mount-Punkte-Isolation - UTS-Namespace: Hostname- und Domainname-Isolation - IPC-Namespace: Interprozesskommunikation-Isolation - Benutzer-Namespace: Benutzer- und Gruppen-ID-Isolation Zusammen schaffen cgroups und Namespaces die Illusion eines separaten Linux-Systems, ohne den Overhead einer vollständigen VM.

Docker und Kubernetes: Das dynamische Duo des Container-Managements

Wenn Docker der Funke war, war Kubernetes das Lauffeuer, das folgte. Zusammen haben sie die Art und Weise, wie wir Anwendungen entwickeln, bereitstellen und verwalten, revolutioniert.

Docker: Der Container-Flüsterer

Docker machte das Erstellen und Ausführen von Containern so einfach wie:

docker run -d -p 80:80 nginx

Plötzlich war "Es funktioniert auf meinem Rechner" keine Ausrede mehr. Docker-Container stellten sicher, dass, wenn es auf dem Laptop eines Entwicklers lief, es auch in der Produktion genauso lief.

Kubernetes: Der Container-Orchestrator

Aber als Container sich vermehrten, wurde das Management zu einer Herausforderung. Betreten Sie Kubernetes, den Dirigenten des Container-Orchesters. Es kümmert sich um Skalierung, Lastverteilung, Service-Entdeckung und mehr. Mit Kubernetes wurde das Bereitstellen und Verwalten containerisierter Anwendungen im großen Maßstab möglich.

apiVersion: apps/v1

kind: Deployment

metadata:

name: nginx-deployment

spec:

replicas: 3

selector:

matchLabels:

app: nginx

template:

metadata:

labels:

app: nginx

spec:

containers:

- name: nginx

image: nginx:1.14.2

ports:

- containerPort: 80

Mikrovirtualisierung: Das Beste aus beiden Welten

Gerade als wir dachten, die Virtualisierungsgeschichte würde sich beruhigen, kam die Mikrovirtualisierung. Es ist, als hätte jemand gesagt: "Was wäre, wenn wir die Sicherheit von VMs mit der Effizienz von Containern kombinieren?"

Firecracker: Amazons Geheimwaffe

Firecracker von Amazon ist ein Paradebeispiel für Mikrovirtualisierung. Es erstellt leichte "MicroVMs", die in Millisekunden starten und einen minimalen Speicherbedarf haben. Es wird verwendet, um AWS Lambda und Fargate zu betreiben und bietet Isolation mit nahezu Container-Performance.

# Starten einer Firecracker-MicroVM

firectl --kernel vmlinux --root-drive alpine.img

Mikrovirtualisierung ist wie das Beste aus beiden Welten - die Sicherheitsisolation von VMs mit der Ressourceneffizienz von Containern.

Virtualisierungssicherheit: Von Hypervisoren zu Containern

Mit der Entwicklung der Virtualisierung entwickelten sich auch die Sicherheitsbedenken. Jede neue Technologie brachte neue Herausforderungen und Lösungen mit sich.

Hypervisor-Sicherheit

Bei traditionellen VMs war der Hypervisor die Hauptsicherheitsgrenze. Ein Kompromiss im Hypervisor könnte potenziell alle VMs betreffen. Dies führte zu gehärteten Hypervisoren und Funktionen wie Intel VT-x und AMD-V für hardwareunterstützte Virtualisierung.

Container-Sicherheit

Container sorgten zunächst für Stirnrunzeln in der Sicherheitsgemeinschaft. Ein Kernel zwischen Containern zu teilen, schien riskant. Dies führte zu Lösungen wie: - gVisor: Ein Userspace-Kernel, der eine zusätzliche Isolationsschicht bietet. - Kata Containers: Leichte VMs, die wie Container aussehen und sich verhalten.

# Einen Container mit gVisor ausführen

docker run --runtime=runsc -d nginx

Die Zukunft der Virtualisierung in Linux: Blick in die Kristallkugel

Was kommt als Nächstes in der sich ständig weiterentwickelnden Welt der Linux-Virtualisierung? Hier sind einige Trends, die Sie im Auge behalten sollten: 1. Serverless Computing: Plattformen wie AWS Lambda treiben die Grenzen dessen, was mit Virtualisierung möglich ist, weiter voran. 2. Unikernels: Spezialisierte, einzweckbetriebssysteme, die die Anwendung und ihre Abhängigkeiten in einem einzigen, leichten Paket bündeln. 3. Edge Computing: Da die Berechnung näher an die Datenquellen rückt, werden wir neue Formen der leichten Virtualisierung sehen, die für Edge-Geräte optimiert sind. 4. KI-gesteuerte Orchestrierung: Maschinelle Lernalgorithmen, die helfen, die Ressourcenzuweisung und Containerplatzierung in Echtzeit zu optimieren.

Fazit: Die unendliche Geschichte der Linux-Virtualisierung

Von den frühen Tagen von Xen bis zur Container-Revolution und darüber hinaus war Linux an der Spitze der Virtualisierungstechnologie. Es hat die Art und Weise, wie wir Anwendungen entwickeln, bereitstellen und verwalten, transformiert und die Ära des Cloud-Computing ermöglicht, in der wir heute leben. Wenn wir in die Zukunft blicken, ist eines klar: Linux wird weiterhin die treibende Kraft hinter der Virtualisierungsinnovation sein. Ob es effizientere Container, intelligentere Orchestrierung oder völlig neue Paradigmen sind, an die wir noch nicht gedacht haben, Linux wird da sein, bereit, sich anzupassen und zu entwickeln. Also, das nächste Mal, wenn Sie einen Container bereitstellen oder eine virtuelle Maschine hochfahren, nehmen Sie sich einen Moment Zeit, um die unglaubliche Reise zu schätzen, die all das möglich gemacht hat. Und denken Sie daran, in der Welt der Linux-Virtualisierung ist die einzige Konstante der Wandel. Bleiben Sie neugierig, lernen Sie weiter, und wer weiß? Vielleicht sind Sie derjenige, der das nächste Kapitel in dieser faszinierenden Geschichte schreibt.

Die beste Möglichkeit, die Zukunft vorherzusagen, ist, sie zu erfinden. - Alan Kay

Nun, wenn Sie mich entschuldigen, ich muss meinen Kaffeeautomaten containerisieren. Man weiß nie, wann man seine Koffeinaufnahme skalieren muss!