Aber warum sollte es dich interessieren? Lass uns das aufschlüsseln:

- Automatische Reaktionen auf Änderungen (keine "Hast du das gesehen?"-Momente mehr)

- Niedrigere Infrastrukturkosten (dein Geldbeutel wird es dir danken)

- Verbesserte Skalierbarkeit (wachse wie Bambus, nicht wie ein Bonsai)

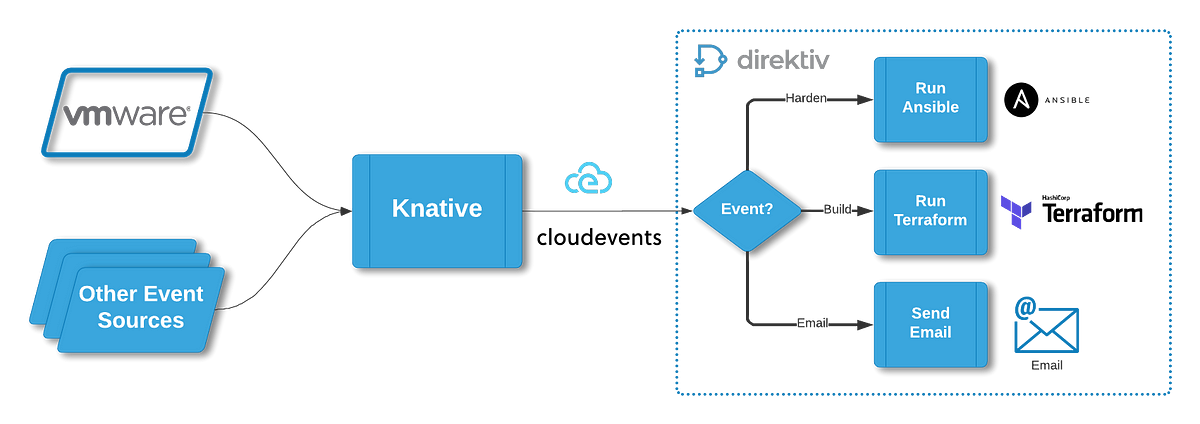

Hier kommen CloudEvents und Knative ins Spiel - das dynamische Duo, das deine serverlosen Träume wahr werden lässt. Sie sind wie Erdnussbutter und Marmelade für deine Cloud-Architektur: einzeln gut, aber zusammen? *perfekt*

CloudEvents: Weil auch Ereignisse Standards verdienen

Erinnerst du dich an den Wilden Westen der Ereignisformate? Jeder Dienst sprach seine eigene Sprache, und du fühltest dich wie ein verwirrter Übersetzer am Turm zu Babel? CloudEvents reitet wie ein Sheriff ein und bringt Gesetz und Ordnung in die Ereigniswelt.

Warum ist das wichtig?

- Standardisierte Ereignisstruktur (keine "Was zum Teufel ist das?"-Momente mehr)

- Einfache Integration mit verschiedenen Quellen und Senken (spiel gut mit anderen)

- Kernattribute, die Sinn machen (id, source, type, time - die fantastischen Vier der Ereignisse)

Werfen wir einen Blick darauf, wie ein CloudEvent aussieht:

{

"specversion" : "1.0",

"type" : "com.example.someevent",

"source" : "/mycontext",

"id" : "A234-1234-1234",

"time" : "2018-04-05T17:31:00Z",

"datacontenttype" : "application/json",

"data" : {

"message" : "Hallo, CloudEvents!"

}

}Sauber, konsistent und, wage ich zu sagen, schön? Es ist, als ob Marie Kondo deine Ereignisdaten aufgeräumt hätte.

Knative: Das Serverlose

Wenn CloudEvents der Sheriff ist, dann ist Knative die gesamte Stadtinfrastruktur. Es ist die Plattform, die serverlose Architektur tatsächlich serverlos macht.

Knatives Superkräfte:

- Serving: Stellt deine Container bereit und skaliert sie

- Eventing: Verwalten und Routen deiner Ereignisse

- Auto-scaling: Skaliert von null auf Held schneller, als du "Traffic-Spitze" sagen kannst

Denke an Knative als deinen persönlichen serverlosen Butler. Es kümmert sich um die Details, damit du dich auf das Wesentliche konzentrieren kannst - Code schreiben, der dich in der Zukunft nicht zum Weinen bringt.

CloudEvents + Knative: Ein himmlisches Paar in der Cloud

Jetzt packen wir es an und sehen, wie diese beiden zusammenarbeiten. Wir werden eine einfache ereignisgesteuerte Funktion einrichten, die auf HTTP-Anfragen reagiert. Denn wer liebt nicht ein gutes "Hallo, Welt!" im Jahr 2023?

Schritt 1: Richte deine Knative-Umgebung ein

Zuallererst, stelle sicher, dass du Knative in deinem Kubernetes-Cluster installiert hast. Wenn nicht, schau dir den offiziellen Knative-Installationsleitfaden an. Es ist einfacher als IKEA-Möbel zusammenzubauen, versprochen.

Schritt 2: Erstelle einen Knative-Dienst

Lass uns einen einfachen Dienst erstellen, der auf HTTP-Anfragen antwortet:

apiVersion: serving.knative.dev/v1

kind: Service

metadata:

name: hello-cloudevents

spec:

template:

spec:

containers:

- image: gcr.io/knative-samples/helloworld-go

env:

- name: TARGET

value: "CloudEvents + Knative"Wende dieses YAML mit kubectl apply -f service.yaml an und sieh zu, wie die Magie passiert.

Schritt 3: Richte eine CloudEvents-Quelle ein

Jetzt erstellen wir eine Ereignisquelle, die CloudEvents an unseren Dienst sendet:

apiVersion: sources.knative.dev/v1

kind: PingSource

metadata:

name: test-ping-source

spec:

schedule: "*/1 * * * *"

data: '{"message": "Hallo, CloudEvents!"}'

sink:

ref:

apiVersion: serving.knative.dev/v1

kind: Service

name: hello-cloudeventsDiese PingSource sendet jede Minute ein CloudEvent an unseren Dienst. Wende es mit kubectl apply -f ping-source.yaml an.

Schritt 4: Sieh dir den Ereignisfluss an

Um deine Ereignisse in Aktion zu sehen, kannst du kubectl logs verwenden, um die Logs deines hello-cloudevents-Dienstes zu überprüfen. Du solltest sehen, wie es CloudEvents wie ein Profi empfängt und verarbeitet.

Knative Eventing: Die Verkehrssteuerung deiner Ereignisstadt

Knative Eventing ist wie ein intelligentes Verkehrssystem für deine Ereignisse. Es sorgt dafür, dass Ereignisse effizient und zuverlässig dorthin gelangen, wo sie hinmüssen.

Wichtige Konzepte:

- Brokers: Denk an sie als Ereigniszentralen

- Triggers: Routen Ereignisse basierend auf ihren Attributen

- Sources: Erzeugen oder importieren Ereignisse aus externen Systemen

Hier ist ein kurzes Beispiel, wie man einen Broker und einen Trigger einrichtet:

apiVersion: eventing.knative.dev/v1

kind: Broker

metadata:

name: default

---

apiVersion: eventing.knative.dev/v1

kind: Trigger

metadata:

name: hello-cloudevents-trigger

spec:

broker: default

subscriber:

ref:

apiVersion: serving.knative.dev/v1

kind: Service

name: hello-cloudeventsDiese Einrichtung erstellt einen Standard-Broker und einen Trigger, der alle Ereignisse an unseren hello-cloudevents-Dienst weiterleitet. Es ist, als ob du deinen Ereignissen ein GPS gibst - sie wissen immer, wohin sie gehen müssen.

Knative Serving: Der Autoscaling-Zauberer

Erinnerst du dich an die Zeiten, als du deine Dienste manuell skalieren musstest? Knative Serving sagt "Nicht mehr!" Es ist, als hättest du einen magischen Skalierungsstab zur Verfügung.

Autoscaling in Aktion:

Knative Serving kann deine Dienste basierend auf Gleichzeitigkeit, Anfragen pro Sekunde oder CPU-Auslastung skalieren. So kannst du es konfigurieren:

apiVersion: serving.knative.dev/v1

kind: Service

metadata:

name: hello-cloudevents

spec:

template:

metadata:

annotations:

autoscaling.knative.dev/target: "10"

spec:

containers:

- image: gcr.io/knative-samples/helloworld-go

env:

- name: TARGET

value: "CloudEvents + Knative"Diese Konfiguration sagt Knative, dass es im Durchschnitt 10 gleichzeitige Anfragen pro Pod aufrechterhalten soll. Es ist, als hättest du einen Türsteher, der sicherstellt, dass dein Club (Dienst) immer die perfekte Kapazität hat - nicht zu voll, nicht zu leer.

CloudEvents: Der universelle Übersetzer

Eines der coolsten Dinge an CloudEvents ist seine Fähigkeit, plattformübergreifend zu arbeiten. Es ist wie Esperanto, aber für Cloud-Ereignisse, und die Leute nutzen es tatsächlich!

Plattformübergreifende Magie:

- AWS EventBridge? Check.

- Azure Event Grid? Klar.

- Google Cloud Pub/Sub? Absolut.

- Dein eigenes On-Prem-Kafka-Cluster? Kein Problem!

CloudEvents bietet SDKs für verschiedene Sprachen, was es einfach macht, Ereignisse zu erzeugen und zu konsumieren. Hier ist ein kurzes Beispiel in Go:

import cloudevents "github.com/cloudevents/sdk-go/v2"

func main() {

c, err := cloudevents.NewDefaultClient()

if err != nil {

log.Fatalf("Fehler beim Erstellen des Clients, %v", err)

}

event := cloudevents.NewEvent()

event.SetID("123")

event.SetType("com.example.test")

event.SetSource("https://example.com/event-producer")

event.SetData(cloudevents.ApplicationJSON, map[string]string{"hello": "world"})

if result := c.Send(context.Background(), event); cloudevents.IsUndelivered(result) {

log.Fatalf("Fehler beim Senden: %v", result)

}

}Damit sprichst du fließend CloudEvents. Deine Ereignisse werden sich zu Hause fühlen, egal ob sie in AWS, Azure, GCP oder deinem eigenen Rechenzentrum sind. Es ist, als ob du deinen Ereignissen einen Multi-Cloud-Pass gibst!

Überwachung: Weil du nicht debuggen kannst, was du nicht siehst

Die Einrichtung der Überwachung für dein Knative- und CloudEvents-Setup ist entscheidend. Es ist, als hättest du eine Kristallkugel, aber für deine serverlose Architektur.

Prometheus und Grafana zur Rettung:

Knative integriert sich gut mit Prometheus zur Metrikensammlung und Grafana zur Visualisierung. Hier ist eine kurze Anleitung, wie du sie einrichtest:

- Installiere Prometheus und Grafana in deinem Cluster (du kannst dafür Helm-Charts verwenden)

- Konfiguriere Prometheus, um Knative-Metriken zu erfassen

- Importiere Knative-Dashboards in Grafana

Sobald alles eingerichtet ist, hast du wunderschöne Dashboards, die dir Metriken wie zeigen:

- Anzahl der Anfragen und Latenzen

- Autoscaler-Metriken (Gleichzeitigkeit, gewünschte Pods usw.)

- Verarbeitete CloudEvents pro Sekunde

Es ist, als hättest du ein Kontrollzentrum für deine serverlosen Apps. Houston, wir haben den Start!

Optimierung von Leistung und Kosten: Der Heilige Gral

Jetzt, da wir unsere serverlose, ereignisgesteuerte Architektur eingerichtet haben, sprechen wir darüber, wie wir sie schlank und effizient machen können.

Tipps zur Optimierung:

- Richtige Größe deiner Funktionen: Verwende keinen Vorschlaghammer, um eine Nuss zu knacken. Stelle sicher, dass deine Funktionen nicht überdimensioniert sind.

- Verwende Techniken zur Optimierung von Kaltstarts: Serverlose Funktionen können bei Kaltstarts langsam sein. Verwende Techniken wie das Vorhalten eines warmen Pools von Instanzen oder die Verwendung leichter Laufzeiten.

- Nutze die feinkörnige Skalierung von Knative: Konfiguriere deine Autoscaling-Parameter sorgfältig, um Reaktionsfähigkeit und Kosten in Einklang zu bringen.

- Batch-Verarbeitung für Effizienz: Wenn möglich, batchweise Verarbeitung von Ereignissen, um die Anzahl der Funktionsaufrufe zu reduzieren.

- Überwachen und anpassen: Überprüfe regelmäßig deine Metriken und passe deine Konfigurationen an. Es ist wie das Abstimmen eines Rennwagens - kleine Anpassungen können zu großen Leistungsgewinnen führen.

Zusammenfassung: Deine serverlose Reise beginnt

Und da hast du es, Leute! Wir haben die Welt von CloudEvents und Knative durchquert und eine serverlose, ereignisgesteuerte Architektur geschaffen, die jeden Cloud-Architekten stolz machen würde.

Denke daran, dies ist erst der Anfang. Die Welt der serverlosen und ereignisgesteuerten Architekturen ist groß und entwickelt sich ständig weiter. Erforsche weiter, lerne weiter und vor allem, baue weiterhin großartige Dinge!

Gehe nun hinaus und möge deine Funktionen skalierbar, deine Ereignisse standardisiert und deine Cloud-Rechnungen immer zu deinen Gunsten sein!

"Der beste Weg, die Zukunft vorherzusagen, ist, sie zu implementieren." - Alan Kay (wahrscheinlich über serverlose Architektur nachdenkend)

Viel Spaß beim Programmieren, und möge dein Kaffee stark und deine Kompilierungszeiten kurz sein!